MD-Blog_Video and Streaming

バーチャルプロダクションシステムの合成ってどんな仕組み?

皆さんこんにちは。

MONSTER DIVEのLIVEプロダクション事業部でテクニカルを担当しています、YOUです。

LIVEプロダクション事業部では、今年の1月からバーチャルプロダクション「Reality」を導入し、さらに映像表現の幅を広げました!

自分は導入直後から「Reality」のオペレータとして従事していますが、CGや合成についての専門知識が全くなかった当時、こんなことを思っていました。

「リアルタイムの合成って、どういう仕組みで出来ているんだ...?」

さぞ難しいことが行われていて仕組みとか絶対理解できないだろうな...と遠い目をしていた覚えがあります。

理解してみると意外とシンプルな仕組みでしたが、ちゃんと理解できるまでには、自分の場合は触って覚えないといけませんでした。また口頭での説明はなかなか難しいので、文章と画像で伝えられるこの機会を逃すまいと思って書いています。笑

そして、この記事を通して少しでもバーチャルプロダクションに興味を持っていただけたら嬉しいです。

ひとつ注意点として、CGについて詳しくない方でもニュアンスを理解していただくためのBlogとなりますので、精密にいえば違うよ〜といった点がちょこちょこあるかもしれませんが、そこはご了承ください。

そもそもバーチャルプロダクションって?

一言でいえば、「バーチャルとリアルを撮影中(リアルタイム)に融合させる技術」です。

もっと嚙み砕けば、リアルタイムでCG合成をする映像技術のことです。

ポイントは「撮影中にリアルタイムでCG合成を行える」という点ですね。

従来のCG合成では、グリーンバックで撮影して、後から編集でCGを加えてから映像が完成していましたが、バーチャルプロダクションでは、撮影の前に合成したいCGを用意し、撮影中に演者の動きや番組の流れに合わせてCGを動かしながら撮影することで、撮影が終了すると共に映像も完成します。

なので、生配信番組などでも収録映像を流すだけでなく、リアルタイムにCG合成が出来ちゃうんです。

リアルタイムで演者の動きに合わせてCGが動くのって、ロマンありますよね!

バーチャルプロダクションシステムを使うと実際にどんな映像ができるのかについては、当社で作成したバーチャルプロダクションのデモVTRが公開されていますので、ぜひ見てみてください!

ロケーションがパッと変わるところなんかは、バーチャルプロダクションだからこそリアルタイムでできる映像表現になっています。

(もちろんCGの後編集は一切入れてません。デモ会の時に「本当に後編集ないんだ!」驚かれるので念の為伝えておきます。笑)

本題! どうやってリアルタイムで合成されているのか

さて、いよいよ本題です。

バーチャルプロダクションシステム「Reality」では、どのようにバーチャルとリアルを融合(つまりCG合成)を行っているのかについて解説していきます。

冒頭で「自分は理解するために触って覚えた」的なことを言いましたが、前提をちゃんと理解できていればそう難しくない話なので、そこも踏まえて解説していきますね!

大前提は、バーチャルカメラでCG空間を撮影しているということ

まず、大前提として「Reality」を使用して出来上がる映像は、バーチャルカメラでCG空間を撮影している映像となります。

まず「バーチャルカメラとはなんぞや?」となるかと思いますが、こちらについてはゲームに例えるとイメージが掴みやすいと思います。

では、『FINAL FANTASY VII REMAKE』を思い浮かべてください。

ゲームプレイ中、主人公のクラウドを操作している時は、クラウドの後ろのやや上辺りから見下ろしているような映像ですよね。

『Apex Legends』や『VALORANT』などのFPSゲームでは、自分が操作しているキャラクターの目で見ているような映像です。

実はゲームプレイ中の映像は、バーチャルカメラで撮影された映像なんです。

悲しいことに、我々リアルの人間はCG空間内に入り込んでこの目で直接CGを見ることはできないわけですが、ゲームなどでもバーチャルカメラを通して、CG空間を覗き見ることができているんです。

それと同じように、「Reality」でもCG空間をバーチャルカメラが撮影→リアルのモニターに出力しているという訳です。

バーチャルカメラは、CG空間とリアルの映像インターフェース的な役割を果たしているんですね。

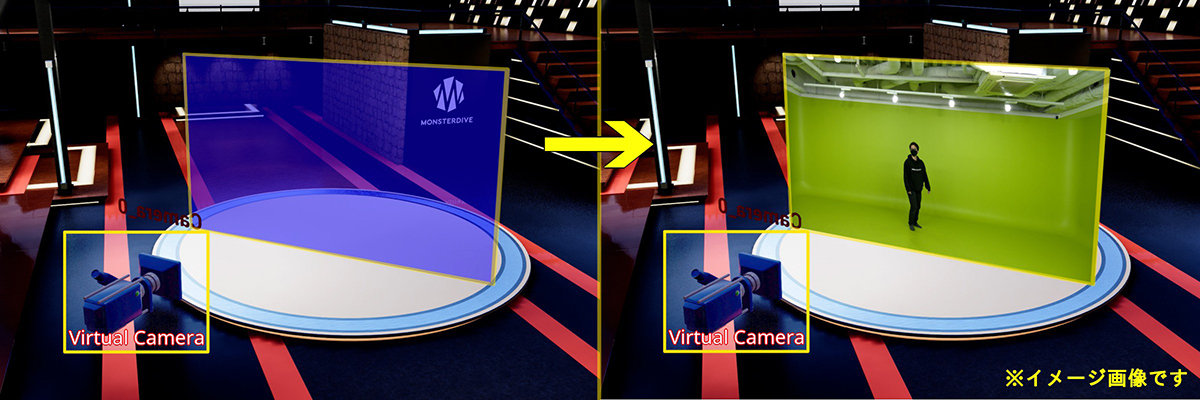

これがバーチャルカメラです。

普段は透過されていて見えないようになっていますが、今回は"バーチャルカメラはこんな感じでCG空間内に存在している"ところをお見せしたくて見える状態にしました。

自分はバーチャルカメラを難しく考えすぎて、理解するのに初っ端から盛大に躓きました。笑

難しく考える必要はひとつもなく、とりあえずゲームプレイ中の画面≒「Reality」で出力される映像と認識してもらえれば一旦OKです!

ここまでで、「バーチャルカメラでCG空間を撮影している映像」というのはなんとなく理解していただけたかとは思いますが、CG空間を撮影するだけでは合成ではないですよね。

バーチャルとリアルの融合 ⸺ つまりCG空間にリアルを入れ込む必要があります。

ではどうやってリアルをCGに入れ込んでいるのかといいますと、なんと1枚のスクリーンのような形で入ります。

「とうとう訳のわからないことを言い出したぞ」と思われるかもしれませんが、事実なんです。

こちらは画像多めで解説していきましょう。

まずはCG空間にバーチャルカメラがあります。これが先程説明した状態です。

ここに、透明なスクリーンを1枚配置し、そこにリアルの映像を映し出します。

これをバーチャルカメラで撮影するとこんな感じ。

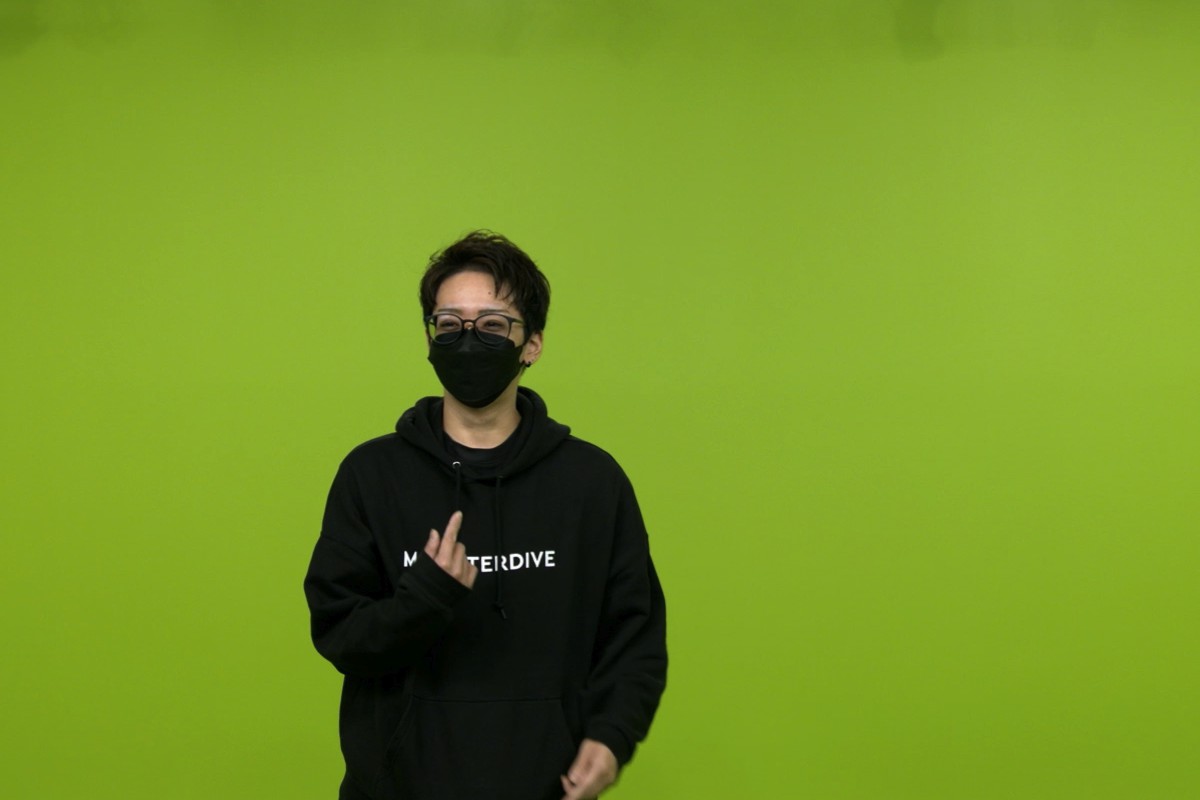

これではただのグリーンバックのリアルの映像ですね。

それではグリーンをキーイングで抜きましょう。

はい、これで合成完了です!

そんなあっさり!?と驚かれるかもしれませんが、仕組みとしては意外とシンプルなんです。

ということで「Reality」での合成は、CG空間にリアルを映し出すスクリーンがあり、バーチャルカメラでスクリーンを含めたCG空間を撮影することで実現できています。

バーチャルカメラの操作方法

ここでもうひとつ疑問が出てくるかと思います。

「合成はできたけど、バーチャルカメラってどうやって動かすの?」

これについては「Reality」を触っていると自然と理解するのですが、そうでない方は操作方法についてイメージしにくいかと思います。

バーチャルカメラには実体がありませんし...。

こちらについてもゲームで例えることになりますが、リアルの映像を撮影しているカメラが、バーチャルカメラのコントローラーとしての役割も果たしています。

レーシングゲームであればハンコン、フライトシューティングゲームではフライトスティックなど、何かを操作する系のゲームでは本物のハンドルなどに似たコントローラーが存在していますが、「Reality」でもバーチャルカメラを動かすのにリアルのカメラを操作します。

リアルのカメラが下を向けば、バーチャルカメラも下を向きます。

ですが、リアルのカメラは元々普通に映像を撮影するカメラを使用しています。コントローラーとして作られたものではありません。

それをどうやってコントローラーとしても使用できるようになっているかというと、トラッキングシステムという、バーチャルプロダクションシステム「Reality」とは別のシステムを付けていることで実現できています。

トラッキングシステムとは、カメラがどれくらい移動したか、どれくらい上下左右に振ったか、どれくらいズームやフォーカスを調整したかなどをデータ化して、コンピューターで処理できるように変換をかけてくれるシステムのことです。

当社では「RedSpy」というシステムを使用しています。 こちらについての詳しい解説は、また別個で記事にできるくらい長くなるので今回は割愛します!

また、理解しやすくするために「バーチャルカメラのコントローラーとしてリアルのカメラを使う」という表現をしましたが、正しくは「リアルのカメラの動きを、トラッキングシステムを使ってコンピューターに読み取らせ、バーチャルカメラを連動させる」という認識です。

リアルのカメラの動きとバーチャルカメラが連動するので、リアルの映像の動きとCG空間内の映像の動きが上手く融合するという訳ですね。

"CG空間を撮影している"からこそできる「Reality」の表現

「Reality」の合成の仕組みが意外とあっさりと解説し終わってしまったのでなんだか物足りないと思うのは、ウキウキで記事を書いている自分だけでしょうか?笑

ということで、"CG空間を撮影している"からこそできる「Reality」の表現について、2つ程ご紹介させてください!

1. フライカメラ

"飛ぶカメラ"で"フライカメラ"。そうです、CG空間内にあるバーチャルカメラは飛ばすことができます!

バーチャルカメラは配置に制限がないので、CG空間のどこにでも配置できます。

そのため、CG空間に配置されたリアルを映し出すスクリーンからバーチャルカメラを離せば、こういう映像も撮れるんです。

白い円盤のステージの上に、降参ポーズにしか見えない手の振り方をしている人が映っているかと思います。

このようなクレーンカメラで撮影したような映像も撮ることができます。

さすがに当社のスタジオはここまで広くはないので(※小規模のスタジオの中ではかなり広々はしていますよ!笑)、こういった引きの絵はリアルでは撮れないんですよね。

ですが「Reality」ならこういう表現もできます。

またリアルカメラとの連携も活きているので、この状態でカメラをワークすることもできますし、事前にアニメーションを組んでおけば、ここから一気に寄ることもできます。

2. リアルの映像に落ちるCGの影

CG合成において、影の存在は合成感(違和感)を軽減してくれる重要な要素です。

CG空間にリアルの人が居ても、CGの影がリアルに被ってくれないと、それだけで一気に合成感が生じてしまいます。

それが「Reality」ではちゃんと表現できます。

当社のシンボルマーク(CG)の影が、人(リアル)に反映されています!

これは「リアルの映像を映し出すスクリーンがCG空間内にある」という話と繋がりますが、このスクリーンもCGの物体(このような物体を「アセット」と呼びます)としてCG空間内に存在しているので、このように影が反映されるんです。

また、グリーンを抜いたところは透明の判定のため、余計な所にはCGの影は落ちないという優れもの。

もちろんCGの影は合成後にできるので、リアルの映像そのままの状態には影が落ちていません。

ちなみにリアルの影もCG内に綺麗に反映されます。

これはCGで作られたものではなく、リアルで落ちている影を、高精度のキーイング技術で綺麗に残すことで表現できています。

従来の手法では、ここまで綺麗に影を残してグリーンを抜くことができなかったので、これもまた「Reality」の強みです。

難しいことはMDにお任せ! お問い合わせお待ちしております

さて、ここまで当社が導入したバーチャルプロダクションシステム「Reality」の合成の仕組みや、「Reality」だからできることなどを解説してきました。

皆さんから少しでも、バーチャルプロダクションは理解不能な難解なものというイメージを払拭してできたらという一心で書き進めてきましたが、いかがだったでしょうか?

合成の仕組み自体はシンプルだということだけでも伝わっていたら嬉しいです。

これを読んでいただいていて、もし「バーチャルプロダクションシステムを使った番組制作に興味が出た」という方は、ぜひ一度お問い合わせいただけたらと思います。

仕組みが簡単=扱うのが簡単という訳ではなく、相当な理解と熟練度が必要になる技術であることには間違いありません。触れば触るほど、「Reality」を完成させた関係者の方々の凄さが身に沁みます。

ですが、難しいことは全部MONSTER DIVEが引き受けますので、「こんな演出がしたい」「こういう表現をみたことあるけど、できますか?」など、やりたいことのイメージさえいただければ、それを表現するお手伝いをさせていただきます!

最後に、よくある質問3つとその回答を載せておきます。

Q. CG空間ありきとなると、0からCGを作らないといけないってこと? お高いでしょう?

A. CG空間は「Unreal Marketplace」にて安価に販売されていて、高くても3万円以内でほとんどのものが購入できます!

ぜひ「Unreal Marketplace」で、イメージに近いスタジオセットを探してみてください。

(上記のアセット購入費と別途にて組み込み費用や、ロゴやスタチューの設置など、ご希望がある場合はカスタマイズ費用などが必要となります)

Q. Unreal Engineのデータが使えるってことだけど、バージョンはいくつ?

A. 当社の「Reality」では、Unreal Engine 4.27との互換性があります。

ですが、つい最近Unreal Engine 5.3のバージョンに対応した「Reality 5」がリリースされました。

当社でもいつかアップデートする...かも?

Q. 撮影の現場がどんな様子なのかを実際に見てみたい。

A. 直近では2024年2月上旬にデモ会を開催予定のため、お問い合わせいただけましたら開催日が確定次第ご連絡致します。

それでは長々と読んでくださりありがとうございました。

バーチャルプロダクションシステムを使用した番組をお考えの方、首を長~~~くしてお待ちしております!

おまけ

「Reality」の導入事例としてインタビューなども受けています。

良かったら見てみてください!

- Recent Entries

-

- やりたい事やったら、みんなが仲良くなった話

- 配信現場ディレクターの1日。 配信の裏側でどのような準備が行われているのか。

- WordPress×Bogoでスムーズな切り替えを実現する 自由度の高い多言語サイト制作

- 誰でも簡単にクイズイベントが開催できる! Webサービス『Quizzy』(クイジー)の魅力を紹介

- 配信・収録・バーチャルプロダクションまで。 「MONSTERSTUDIO乃木坂」の活用方法を紹介

- チームリーダーとして、バラバラな強みをひとつのチームにするということ

- 【18年目の挑戦】MONSTER DIVE 2026 KICK-OFF!

- 「課題を解く力」で世の中を動かす--WEBプロダクション事業部2026年の決意

- 2025年17期を振り返って。さらなる高みを目指す18期への決意

- Webデザイナー、急にYouTuberデビュー

- MD EVENT REPORT

-

- よりよいモノづくりは、よい仲間づくりから 「チームアクティビティ支援制度」2025年活動報告!

- MDの新年はここから。毎年恒例の新年のご祈祷と集合写真

- 2024年もMONSTER DIVE社内勉強会を大公開!

- 社員旅行の計画は「コンセプト」と「事前準備」が重要! 幹事さん必見! MONSTER DIVEの社内イベント事例

- 5年ぶりの開催! MONSTER DIVE社員旅行2024 "Build Our Team"!

- よいモノづくりは、よい仲間づくりから 「チームアクティビティ支援制度」2023年活動報告!

- 2023年のMONSTER DIVE勉強会を大公開!

- リフレッシュ休暇の過ごし方

- 勤続10周年リフレッシュ25連休で、思考をコンマリしたりタイに行った話。

- 俺たちのフジロック2022(初心者だらけの富士山登山)

- What's Hot?

-

- 柔軟に対応できるフロントエンド開発環境を構築する 2022

- 楽しくチームビルディング! 職場でおすすめのボードゲームを厳選紹介

- ライブ配信の現場で大活躍! 「プロンプター」とは?

- 名作ゲームに学べ! 伝わるUI/UXデザインのススメ

- 映像/動画ビギナーに捧げる。画面サイズの基本と名称。

- [2020最新版] Retinaでもボケない、綺麗なfaviconの作り方

- ビット(bit), バイト(Byte), パケット。ついでにbps。 〜後編「で、ビットとバイトって何が違うの?」〜

- 有名企業やブランドロゴに使われているフォントについて調べてみる。

- 算数ドリル ... 2点間の距離と角度

- 画面フロー/システムフローを考えよう!

- タグリスト

-

- #Webデザイン

- #JavaScript

- #MONSTER DIVE

- #ライブ配信

- #映像制作

- #Movable Type

- #CMS

- #ワークスタイル

- #MONSTER STUDIO

- #Webプロモーション

- #Web開発

- #Webディレクターのノウハウ

- #アプリ

- #Creators Lab まとめ

- #MTタグを極める

- #MD社内イベント

- #効率化

- #Webクリエイティブ

- #CSS

- #撮影

- #Webディレクション

- #プランニング

- #コーディング

- #ストリーミング配信

- #オーサリング

- #クレバー藤原

- #スマートフォン

- #早朝がいちばん捗るヒト

- #PowerCMS

- #WEBサービス

- #ライブ中継

- #グラフィックデザイン

- #人事

- #サマンサ先生

- #AI

- #Android

- #Webメディア

- #まとめ

- #ディレクション

- #HTML5

- #iPhone

- #プラグイン

- #プログラミング

- #新入社員

- #iOS

- #jquery

- #RIDE HI

- #UI/UXデザイン

- #アニメーション

- #Adobe